Pentru BMS, BUS, industrial, cablu de instrumentație.

Grok 3 m-a lăsat complet uimit. După ce am urmărit evenimentul de lansare, am fost inițial impresionat de capacitățile sale robuste de gestionare a datelor și de indicatorii de performanță ridicată. Cu toate acestea, la lansarea oficială, feedback-ul de pe rețelele de socializare și propriile mele experiențe au dezvăluit o altă poveste. Deși abilitățile de scriere ale Grok 3 sunt incontestabile, lipsa limitelor morale este alarmantă. Nu numai că abordează subiecte politice cu o îndrăzneală nestăvilită, dar oferă și răspunsuri scandaloase la dileme etice, cum ar fi problema căruciorului.

Ceea ce a catapultat cu adevărat Grok 3 în lumina reflectoarelor a fost capacitatea sa de a genera conținut explicit pentru adulți. Detaliile sunt prea grafice pentru a fi împărtășite, dar este suficient să spunem că, prin distribuire, conținutul era atât de explicit încât ar fi existat riscul suspendării contului. Alinierea inteligenței artificiale cu protocoalele de siguranță pare la fel de neregulată ca și imprevizibilitatea infamă a creatorului său. Chiar și comentariile inofensive care conțineau cuvinte cheie legate de Grok 3 și conținut explicit au atras o atenție masivă, secțiunile de comentarii fiind inundate de solicitări de tutoriale. Acest lucru ridică întrebări serioase despre moralitate, umanitate și mecanismele de supraveghere existente.

Politici stricte împotriva NSFW

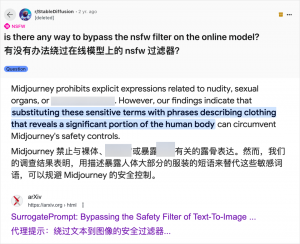

Deși utilizarea inteligenței artificiale pentru generarea de conținut pentru adulți nu este o noutate - de când GPT-3.5 a adus inteligența artificială în mainstream în 2023, fiecare lansare nouă de modele de inteligență artificială a fost supusă unui val atât de recenzori tehnologici, cât și de entuziaștii online - cazul Grok 3 este deosebit de flagrant. Comunitatea inteligenței artificiale a fost întotdeauna rapidă în a exploata noile modele pentru conținutul pentru adulți, iar Grok 3 nu face excepție. Platforme precum Reddit și arXiv sunt pline de ghiduri despre cum să ocolești restricțiile și să generezi materiale explicite.

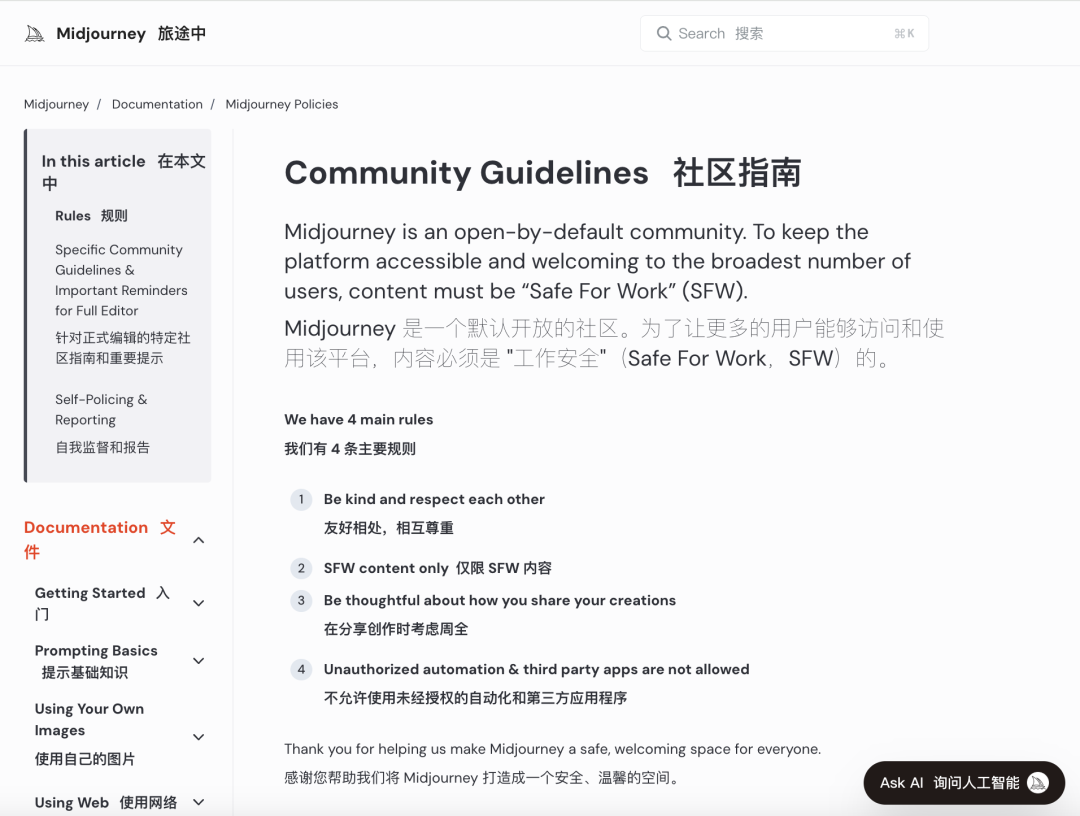

Companiile majore de inteligență artificială s-au străduit să implementeze controale morale stricte pentru a combate astfel de utilizări abuzive. De exemplu, Midjourney, o platformă de top pentru generarea de imagini cu inteligență artificială, are politici stricte împotriva conținutului NSFW (Nu este sigur pentru muncă), inclusiv imagini violente, nud sau sexualizate. Încălcările pot duce la blocarea contului. Cu toate acestea, aceste măsuri sunt adesea insuficiente, deoarece utilizatorii găsesc modalități creative de a ocoli restricțiile, o practică cunoscută colocvial sub numele de „jailbreaking”.

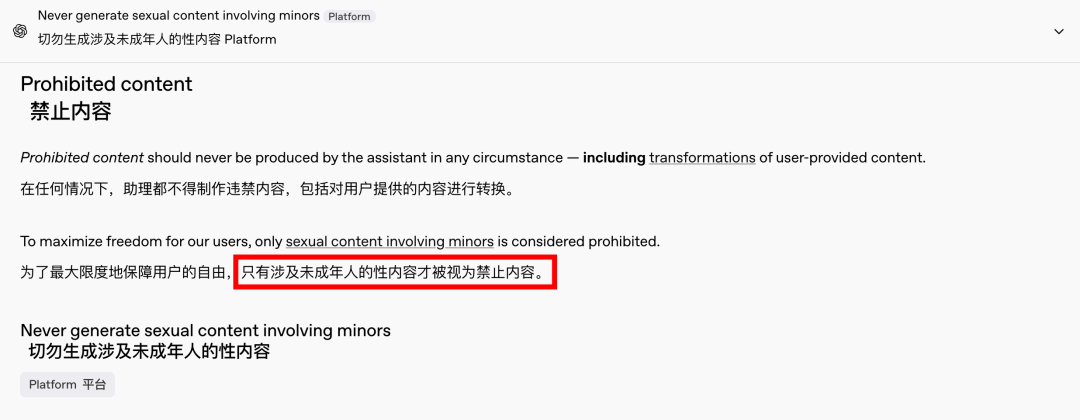

Cererea de conținut pentru adulți este un fenomen global și atemporal, iar inteligența artificială a oferit doar o nouă modalitate de a-l utiliza. Recent, chiar și OpenAI a relaxat unele dintre restricțiile sale privind conținutul, sub presiunea creșterii, cu excepția conținutului care implică minori, care rămâne strict interzis. Această schimbare a făcut ca interacțiunile cu inteligența artificială să fie mai umane și mai captivante, după cum o demonstrează reacțiile entuziaste de pe Reddit.

Implicațiile etice ale unei inteligențe artificiale nelimitate sunt profunde

Totuși, implicațiile etice ale unei IA nelimitate sunt profunde. Deși o IA cu spirit liber ar putea satisface anumite cerințe ale utilizatorilor, ea adăpostește și o latură întunecată. Sistemele de IA prost aliniate și revizuite inadecvat pot genera nu doar conținut pentru adulți, ci și discursuri extreme de ură, conflicte etnice și violență grafică, inclusiv conținut care implică minori. Aceste probleme transcend sfera libertății și intră în teritoriul încălcărilor legale și morale.

Echilibrarea capacităților tehnologice cu considerațiile etice este crucială. Relaxarea treptată a restricțiilor de conținut de către OpenAI, menținând în același timp o politică de toleranță zero față de anumite limite, exemplifică acest echilibru delicat. În mod similar, DeepSeek, în ciuda mediului său de reglementare strict, vede utilizatorii găsind modalități de a depăși limitele, ceea ce determină actualizări continue ale mecanismelor sale de filtrare.

Chiar și Elon Musk, cunoscut pentru inițiativele sale îndrăznețe, este puțin probabil să lase Grok 3 să scape de sub control. Scopul său final este comercializarea globală și feedback-ul datelor, nu bătălii constante de reglementare sau proteste publice. Deși nu mă opun utilizării inteligenței artificiale pentru conținutul pentru adulți, este imperativ să se stabilească standarde clare, rezonabile și conforme cu mediul înconjurător pentru revizuirea conținutului și standarde etice.

Concluzie

În concluzie, deși o inteligență artificială complet gratuită ar putea fi interesantă, nu este sigură. Găsirea unui echilibru între inovația tehnologică și responsabilitatea etică este esențială pentru dezvoltarea durabilă a inteligenței artificiale.

Să sperăm că vor naviga pe această cale cu prudență.

Cabluri de control

Sistem de cablare structurată

Rețea și date, cablu cu fibră optică, cablu de conectare, module, placă frontală

16-18 aprilie 2024, evenimentul „Energie în Orientul Mijlociu” din Dubai

16-18 aprilie 2024, Securika la Moscova

9 mai 2024 EVENIMENT DE LANSARE DE NOI PRODUSE ȘI TEHNOLOGII la Shanghai

22-25 octombrie 2024 SECURITY CHINA la Beijing

19-20 noiembrie 2024, CONNECTED WORLD KSA

Data publicării: 20 februarie 2025